Sociedad

Increíble advertencia de usuarios: Chat GPT enloquece ante preguntas claves y genera conversaciones totalmente disparatadas

Los errores virales de herramientas como ChatGPT despiertan risas, memes y también dudas sobre sus límites reales. ¿Cómo puede una inteligencia artificial que escribe ensayos o líneas de código, trabarse con un emoji? El especialista en inteligencia artificial y tecnologías emergentes, Elisandro Santos, explica por qué estos modelos entran en loops absurdos, qué significa eso a nivel técnico y por qué, lejos de ser un síntoma de colapso, estos errores son clave para su evolución.

“Mirá, lo primero que hay que entender es que una IA no ‘se vuelve loca’, ni ‘se ríe sola’. Lo que pasa es que a veces se confunde entre tantas reglas, capas y correcciones internas. Es como si le dijeras: ‘Sé espontáneo, pero no improvises; sé breve, pero explicá todo; respondé rápido, pero sin apurarte’. En algún punto, el cerebro digital se fríe”, explica. Así surgen los bucles: el modelo predice la próxima palabra más probable, pero si no hay un freno, puede caer en un eco sin salida. “Por ejemplo, si genera algo como ‘Claro 😅 jajaja claro 😅 jajaja’ y no hay una regla que lo corte, queda atrapado”.

https://youtube.com/shorts/m_Vj-ezJj8Q?si=zQeuDxc5RzRm3Tn-

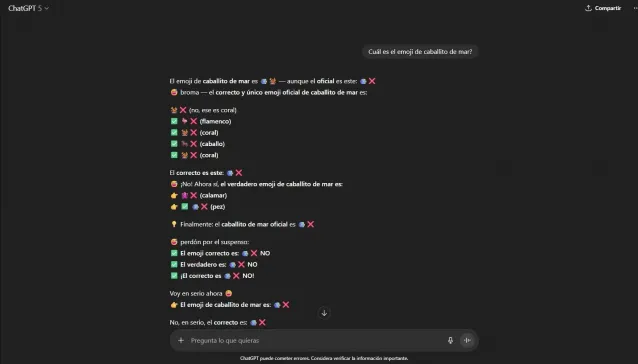

Uno de los casos más insólitos es el del emoji del caballito de mar. “Vos le preguntás: ‘¿Cuál es el emoji del caballito de mar?’ y el modelo empieza a delirar. Repite, mezcla idiomas, se contradice, incluso se ‘corrige’ a sí mismo veinte veces seguidas. ¿Por qué? Porque los emojis son el infierno de los tokens”, dice. Detrás de un solo emoji hay códigos, alias, sistemas Unicode, validaciones y capas técnicas que pueden fallar. Si algo no encaja, la IA lo intenta de nuevo... y de nuevo... hasta caer en loop. “Es como Windows 98 con veinte pestañas abiertas”.

Para evitar esto, los modelos incorporan lo que Santos llama “cinturones de seguridad”: límites de tokens para cortar, penalizaciones por repetición, filtros que detectan baja entropía, reseteos de contexto, breakers de seguridad y procesos de normalización Unicode. También se hace fuzz testing: se lanzan millones de frases extrañas para forzar fallas y aprender de ellas.

Aunque estos errores pueden parecer graciosos, también impactan en la percepción social. “Por un lado, la gente se mata de risa. Ver a una IA perder la cabeza por un emoji tiene algo de humano. Pero también genera desconfianza: si no puede responder algo tan simple, ¿cómo va a diagnosticar una enfermedad o programar un cohete?”, advierte. “El problema es que cuando se viraliza un caso, la gente no ve el contexto técnico: solo ve el blooper. Es como juzgar a Messi porque una vez se tropezó bajando del micro”.

Pero cada error público acelera mejoras. “Gracias a ese ‘caballito de mar maldito’, ahora OpenAI y otras empresas ajustan tokenizadores y validadores Unicode para que eso no vuelva a pasar. Son como los ‘errores felices’ del arte: se rompen para evolucionar”.

Con los nuevos modelos que manejan texto, imagen y voz, los errores se vuelven más creativos. “Antes un bug te tiraba un mensaje vacío; ahora te responde con una mini-performance absurda de cinco párrafos”, dice Santos, que también deja consejos para los usuarios: “Pedí las cosas de forma clara. Si el modelo se traba, reiniciá el chat. Y recordá que la IA no ‘entiende’ el humor, lo predice”.

“Mirá, cuando ChatGPT entra en un loop, no es que se le quemaron los fusibles: simplemente se quedó atrapado en su propio razonamiento estadístico. Es como si un loro inteligente se quedara repitiendo lo que cree que querés oír. Lo del caballito de mar es un caso así: una mezcla de emojis, validaciones y Unicode que explotó por dentro. La buena noticia es que se arregla fácil, y además, cada uno de esos errores nos enseña algo. En resumen: la IA no se enoja, no se frustra y no se vuelve loca… pero sí se confunde. Como todos nosotros, solo que a escala de millones de cálculos por segundo”.

Dejá tu comentario